网站打开慢怎么办?(robots文件降低网络爬虫速度减小压力)

有些站长经常抱怨自己的网站打开速度很慢,用了各种方法都不起效果。也找不到影响网站打开慢的真正原因。对于我们学做网站论坛检测的一部分网站中,有一部分网站打开慢是由于网站被大量网络爬虫频繁的访问造成的。

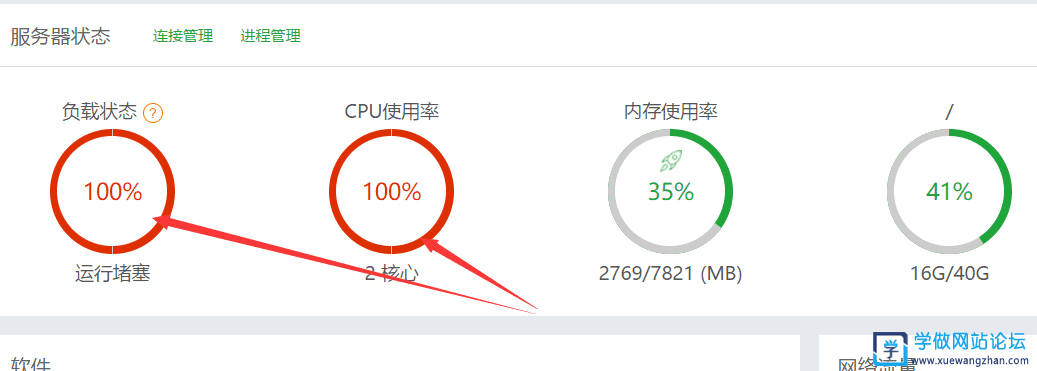

我们网络爬虫也就是我们SEO课程中讲的搜索引擎蜘蛛,我们网站想要在搜索引擎上有排名,第一步就是让搜索蜘蛛抓取我们的网站。但是网络上有大量的垃圾蜘蛛,会肆无忌惮的不停访问我们的网站,这样会给自己的网站服务器增加很大的负担,甚至服务器CPU使用率/负载状态达100%。这时我们需要降低网络爬虫速度减小压力。

降低网络爬虫速度的方法很简单,在robots.txt文件里就可以通过代码来降低速度。

User-agent: *

Crawl-delay: 10

Request-rate: 60/1m

Visit-time: 0000-0800

由于这个还没有完全的标准,两种都用了,Crawl-delay是每秒访问的网页数,而Request-rate是页面数/时间段,可以设置为比较小的值,Visit-time为允许访问的时间段。

当然,我们也可以把一些常见的垃圾蜘蛛屏蔽掉,不让他们来抓取我们的网站。方法见:https://www.xuewangzhan.net/wenti/65988.html